ChatGPT është një emër i njohur për më pak se një vit, por algoritmet që punojnë në sfondin e mjetit popullor të AI në fakt kanë fuqizuar një gamë të tërë aplikacionesh dhe shërbimesh që nga viti 2020. Vlogeri i njohur Nas Daily e shpjegon në hapa të thjeshtë përmes videos katërminutëshe që mund ta shihni më poshtë.

Për juve që dëshironi ta keni të lexuar, artikulli më poshtë jep sqarime të detajuara.

Pra, për të kuptuar se si funksionon ChatGPT, duhet të fillojmë duke folur për motorin themelor të gjuhës që e fuqizon atë. GPT në ChatGPT janë kryesisht dy algoritme të lidhura: GPT-3.5 Turbo dhe GPT-4, megjithëse kjo e fundit është e disponueshme vetëm në ChatGPT për abonentët e ChatGPT Plus. Biti GPT do të thotë Transformues Prodhues i Trajnuar paraprakisht dhe numri është vetëm versioni i algoritmit. Modelet GPT u zhvilluan nga OpenAI (kompania që qëndron pas ChatGPT dhe gjeneratorit të imazheve DALL·E 2), por ato fuqizojnë gjithçka, nga veçoritë e AI të Bing deri te mjetet e shkrimit si Jasper dhe Copy.ai. Në fakt, shumica e gjeneratorëve të tekstit të AI-së të disponueshëm për momentin përdorin GPT-3, GPT-3.5 dhe GPT-4.

Ndërtoni chatbotin tuaj të AI

ChatGPT vendosi GPT në qendër të vëmendjes sepse e bëri procesin e ndërveprimit me një gjenerues teksti AI të thjeshtë dhe – më e rëndësishmja – falas për të gjithë. Plus, është një chatbot dhe njerëzit kanë dashur një chatbot të mirë që nga SmarterChild.

Ndërsa GPT-3.5 dhe GPT-4 janë modelet më të njohura të gjuhëve të mëdha (LLM) tani, gjatë disa viteve të ardhshme, ka të ngjarë të ketë shumë më tepër konkurrencë. Google, për shembull, ka Bard – chatbotin e tij AI – i cili mundësohet nga motori i tij gjuhësor, Pathways Language Model (PaLM 2). Meta, kompania mëmë e Facebook, publikoi Llama 2, LLM-në e saj më të fundit. Dhe pastaj ka opsione të tjera që synojnë kompanitë e mëdha, si Writer’s Palmyra LLMs dhe Anthropic’s Claude. Megjithatë, të paktën tani për tani, oferta e OpenAI është standardi de fakto i industrisë. Është thjesht mjeti më i lehtë për njerëzit që ta kenë në dispozicion.

Pra, përgjigja për “si funksionon ChatGPT?” është në thelb: GPT-3.5 dhe GPT-4. Por le të gërmojmë pak më thellë.

Me Zapier, ju mund të lidhni ChatGPT me mijëra aplikacione të tjera për të sjellë AI në të gjitha flukset e punës tuaj kritike për biznesin.

Çfarë është ChatGPT?

ChatGPT është një aplikacion i krijuar nga OpenAI. Duke përdorur modelet e gjuhës GPT, ai mund t’u përgjigjet pyetjeve tuaja, të shkruajë kopje, të hartojë email, të zhvillojë një bisedë, të shpjegojë kodin në gjuhë të ndryshme programimi, të përkthejë gjuhën natyrore në kod dhe më shumë – ose të paktën të përpiqet – të gjitha bazuar në gjuhën natyrore me të cilën ju bën ta ushqeni atë. Është një chatbot, por vërtet shumë i mirë.

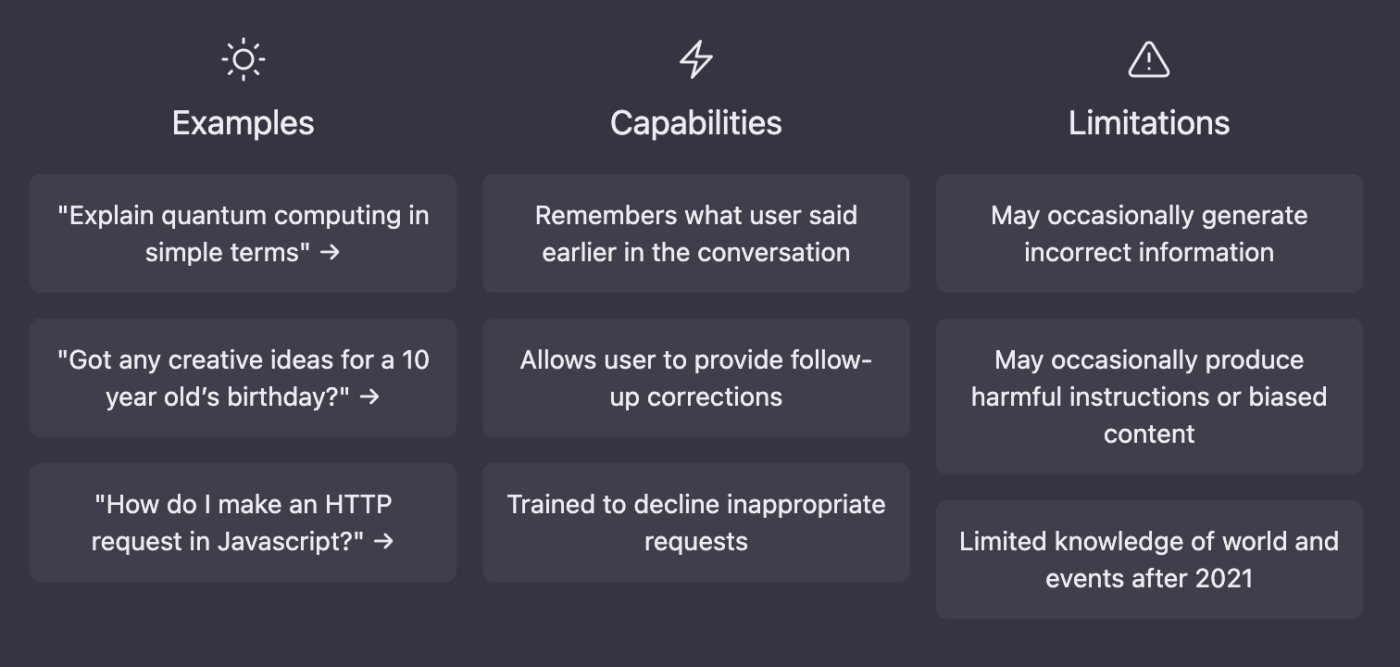

Shembuj, aftësitë dhe kufizimet e ChatGPT

Ndërsa është bukur të luash me të, për shembull, nëse dëshiron të shkruash një sonet shekspirian për kafshën tënde ose të marrësh disa ide për linjat e subjektit për disa emaile marketingu, edhe këto gjëra nuk janë ndonjë vështirësi për OpenAI. Është një mënyrë për të marrë shumë të dhëna nga përdoruesit e vërtetë dhe shërben si një demonstrim i mrekullueshëm për fuqinë e GPT, i cili përndryshe mund të tingëllojë pak i turbullt nëse nuk hyni thellë në mësimin e makinerive. (Ky grumbullim i të dhënave nxiti bllokimin e ChatGPT në Itali në fillim të vitit 2023, megjithëse shqetësimet e rregullatorëve italianë tani janë zgjidhur.)

Tani për tani, ChatGPT ofron dy modele GPT. Parazgjedhja, GPT-3.5, është më pak e fuqishme, por e disponueshme për të gjithë falas. GPT-4 më i avancuar është i kufizuar për abonentët e ChatGPT Plus, madje ata mund të bëjnë një numër të kufizuar pyetjesh në ditë. (Aktualisht janë 25 mesazhe çdo tre orë, por kjo mund të ndryshojë.)

Një nga veçoritë kryesore të ChatGPT është se mund të kujtojë bisedën që po bëni me të. Kjo do të thotë se mund të mbledhë kontekstin nga çdo gjë që i keni kërkuar më parë dhe më pas ta përdorë atë për të informuar bisedën e tij me ju. Ju gjithashtu mund të kërkoni për ripunime dhe korrigjime, dhe kjo do t’i referohet çdo gjëje që keni diskutuar më parë. Kjo e bën bashkëveprimin me AI të ndihet si një lëvizje e vërtetë para-prapa.

Nëse dëshironi ta ndjeni vërtet atë, shkoni dhe kaloni pesë minuta duke luajtur me ChatGPT tani (është falas!) dhe më pas kthehuni për të lexuar se si funksionon.

Si funksionon ChatGPT?

Ky grup i madh i të dhënave u përdor për të formuar një rrjet nervor të të mësuarit të thellë […] i modeluar sipas trurit të njeriut – i cili lejoi ChatGPT të mësonte modele dhe marrëdhënie në të dhënat e tekstit […] duke parashikuar se cili tekst duhet të vijë më pas në çdo fjali të caktuar .

ChatGPT funksionon duke u përpjekur të kuptojë kërkesën tuaj dhe më pas duke nxjerrë vargjet e fjalëve që ai parashikon se do t’i përgjigjen më së miri pyetjes suaj, bazuar në të dhënat mbi të cilat është trajnuar. Ndonëse kjo mund të duket relativisht e thjeshtë, kjo fsheh kompleksitetin e asaj që ndodh nën mbulesë.

Mësimi i mbikëqyrur kundrejt të mësuarit të pambikëqyrur

Le të flasim në fakt për trajnimin. P në GPT do të thotë “i trajnuar paraprakisht” dhe është një pjesë shumë e rëndësishme se pse GPT është në gjendje të bëjë atë që mund të bëjë.

Përpara GPT, modelet më të mira të inteligjencës artificiale përdorën “të mësuarit e mbikëqyrur” për të zhvilluar algoritmet e tyre themelore. Ata u trajnuan me të dhëna të etiketuara manualisht, si një bazë të dhënash me foto të kafshëve të ndryshme të çiftuara

me një përshkrim teksti të çdo kafshe të shkruar nga njerëzit. Këto lloj të dhënash trajnimi, megjithëse janë efektive në disa rrethana, janë tepër të shtrenjta për t’u prodhuar. Edhe tani, thjesht nuk ka aq shumë të dhëna të etiketuara dhe kategorizuara në mënyrë të përshtatshme për t’u përdorur për të trajnuar LLM.

Në vend të kësaj, GPT përdori para-trajnim gjenerues, ku iu dhanë disa rregulla bazë dhe më pas u ushqye me sasi të mëdha të dhënash të paetiketuara – afër të gjithë internetit të hapur. Më pas u la “i pambikëqyrur” për të gërmuar të gjitha këto të dhëna dhe për të zhvilluar kuptimin e vet të rregullave dhe marrëdhënieve që rregullojnë tekstin.

Sigurisht, ju nuk e dini vërtet se çfarë do të merrni kur përdorni mësimin e pambikëqyrur, kështu që GPT është gjithashtu “i rregulluar mirë” për ta bërë sjelljen e tij më të parashikueshme dhe të përshtatshme. Ka disa mënyra për ta bërë këtë, por shpesh përdor forma të të mësuarit të mbikëqyrur.

Arkitektura e transformatorëve

I gjithë ky trajnim synon të krijojë një rrjet nervor të të mësuarit të thellë – një algoritëm kompleks, me shumë shtresa, i peshuar i modeluar sipas trurit të njeriut – i cili i mundësoi ChatGPT të mësojë modele dhe marrëdhënie në të dhënat e tekstit dhe të përdorë aftësinë për të krijuar përgjigje të ngjashme me ato të njerëzve, duke parashikuar se cili tekst duhet të vijë më pas në çdo fjali të dhënë.

Ky rrjet përdor diçka të quajtur arkitekturë transformatorësh (T në GPT) dhe u propozua në një studim kërkimor në vitin 2017. Është absolutisht thelbësor për bumin aktual në modelet e AI.

Ndërsa tingëllon – dhe është – e ndërlikuar kur e shpjegoni, modeli i transformatorit thjeshtoi rrënjësisht se si u projektuan algoritmet e AI. Ai lejon që llogaritjet të paralelizohen (ose të bëhen në të njëjtën kohë), që do të thotë reduktim i ndjeshëm i kohës së trajnimit. Jo vetëm që i bëri më të mirë modelet e AI, por i bëri ato më të shpejta dhe më të lira për t’u prodhuar.

Në thelb të transformatorëve është një proces i quajtur “vetë-vëmendje”. Rrjetet nervore periodike më të vjetra (RNN) lexojnë tekstin nga e majta në të djathtë. Kjo është mirë kur fjalët dhe konceptet e lidhura janë pranë njëri-tjetrit, por i bën gjërat të komplikuara kur ato janë në skajet e kundërta të fjalisë. (Është gjithashtu një mënyrë e ngadaltë për të llogaritur gjërat pasi duhet të bëhet në mënyrë sekuenciale.)

Megjithatë, transformatorët lexojnë çdo fjalë në një fjali menjëherë dhe e krahasojnë secilën fjalë me të gjitha të tjerat. Kjo u lejon atyre të drejtojnë “vëmendjen” e tyre te fjalët më të rëndësishme, pavarësisht se ku janë në fjali. Dhe kjo mund të bëhet paralelisht në pajisje kompjuterike moderne.

Natyrisht, e gjithë kjo thjeshton shumë gjërat. Transformatorët nuk punojnë me fjalë, ata punojnë me “shenja”, të cilat janë pjesë të tekstit të koduara si vektor (një numër me pozicion dhe drejtim). Sa më afër të jenë dy vektorë-token në hapësirë, aq më të lidhur janë ata. Në mënyrë të ngjashme, vëmendja është e koduar si një vektor, i cili lejon rrjetet nervore të bazuara në transformator të mbajnë mend informacione të rëndësishme nga më parë në një paragraf.

Dhe kjo është para se të futemi në matematikën themelore se si funksionon kjo. Ndërsa është përtej qëllimit të këtij artikulli për të hyrë në të, Mjeshtëria e Mësimit të Makinerisë ka disa shpjegues që zhyten në anën teknike të gjërave.

Shenjat

Mënyra se si teksti kuptohet nga modelet e AI është gjithashtu e rëndësishme, kështu që le të hyjmë pak më thellë te shenjat. GPT-3 u trajnua në afërsisht 500 miliardë argumente, gjë që lejon modelet e saj gjuhësore të caktojnë më lehtë kuptimin dhe të parashikojnë tekstin e besueshëm pasues duke i hartuar në hapësirën vektoriale. Shumë fjalë hartohen në shenja të vetme, megjithëse fjalët më të gjata ose më komplekse shpesh ndahen në shenja të shumta. Mesatarisht, shenjat janë afërsisht katër karaktere të gjata. OpenAI ka qëndruar i heshtur për funksionimin e brendshëm të GPT-4, por mund të supozojmë me siguri se është trajnuar në të njëjtin grup të dhënash pasi është edhe më i fuqishëm.

Të gjitha argumentet erdhën nga një korpus masiv i të dhënave të shkruara nga njerëzit. Kjo përfshin libra, artikuj dhe dokumente të tjera në të gjitha temat, stilet dhe zhanret e ndryshme—dhe një sasi të pabesueshme përmbajtjesh të fshirë nga interneti i hapur. Në thelb, u lejua të gërmohej në shumën totale të njohurive njerëzore për të zhvilluar rrjetin që ai përdor për të gjeneruar tekst.

Bazuar në gjithë atë trajnim, rrjeti nervor i GPT-3 ka 175 miliardë parametra ose variabla që e lejojnë atë të marrë një hyrje – kërkesën tuaj – dhe më pas, bazuar në vlerat dhe peshën që u jep parametrave të ndryshëm (dhe një sasi të vogël rastësie ), nxjerr çfarëdo që mendon se përputhet më mirë me kërkesën tuaj. OpenAI nuk ka thënë se sa parametra ka GPT-4, por është një supozim i sigurt se është më shumë se 175 miliardë dhe më pak se 100 trilion parametrat e përfolur dikur. Pavarësisht nga numri i saktë, më shumë parametra nuk do të thotë automatikisht më mirë. Një pjesë e fuqisë së shtuar të GPT-4 ndoshta vjen nga më shumë parametra se GPT-3, por shumë ndoshta varet nga përmirësimet në mënyrën se si u trajnua.

Të mësuarit përforcues nga reagimet njerëzore (RLHF)

Sigurisht, rrjeti nervor fillestar i GPT ishte krejtësisht i papërshtatshëm për publikim. Në fund të fundit, ai u trajnua në internet të hapur, pothuajse pa asnjë udhëzim. Kështu që,për të përmirësuar më tej aftësinë e ChatGPT për t’iu përgjigjur një sërë kërkesave të ndryshme në një mënyrë të sigurt, të ndjeshme dhe koherente, ai u optimizua për dialog me një teknikë të quajtur të mësuarit përforcues me reagime njerëzore (RLHF).

Në thelb, OpenAI krijoi disa të dhëna demonstruese që i treguan rrjetit nervor se si duhet të përgjigjet në situata tipike. Nga kjo, ata krijuan një model shpërblimi me të dhëna krahasimi (ku dy ose më shumë përgjigje modelesh u renditën nga trajnerët e AI), në mënyrë që AI të mund të mësonte se cila ishte përgjigja më e mirë në çdo situatë të caktuar. Megjithëse nuk është mësim i pastër i mbikëqyrur, RLHF lejon që rrjetet si GPT të akordohen në mënyrë efektive.

Përpunimi i gjuhës natyrore (NLP)

E gjithë kjo përpjekje synon ta bëjë GPT sa më efektive në përpunimin e gjuhës natyrore (NLP). NLP është një kategori e madhe kovë që përfshin shumë aspekte të inteligjencës artificiale, duke përfshirë njohjen e të folurit, përkthimin e makinës dhe chatbots, por mund të kuptohet si procesi përmes të cilit Al mësohet të kuptojë rregullat dhe sintaksën e gjuhës, të programuar për të zhvilluar algoritme komplekse për të përfaqësuar ato rregulla, dhe më pas u bënë të përdorin ato algoritme për të kryer detyra specifike.

Meqenëse kam mbuluar anën e trajnimit dhe zhvillimit të algoritmit të gjërave, le të shohim se si NLP i mundëson GPT të kryejë detyra të caktuara – në veçanti, duke iu përgjigjur kërkesave të përdoruesit.

Është e rëndësishme të kuptohet se për gjithë këtë diskutim të argumenteve, ChatGPT po gjeneron tekstin e fjalëve, fjalive dhe madje edhe paragrafëve ose strofave që mund të pasojnë. Nuk është teksti parashikues në telefonin tuaj që hamendëson troç fjalën tjetër; por përpiqet të krijojë përgjigje plotësisht koherente për çdo kërkesë. Kjo është ajo që transformatorët sjellin në NLP.

Në fund, mënyra më e thjeshtë për ta imagjinuar është si një nga ato lojërat “përfundo fjalinë” që ke luajtur si fëmijë. ChatGPT fillon duke marrë kërkesën tuaj, duke e zbërthyer në tokena dhe më pas duke përdorur rrjetin e tij nervor të bazuar në transformator për t’u përpjekur të kuptoni se cilat janë pjesët më të spikatura të tij dhe çfarë po i kërkoni në të vërtetë të bëjë. Nga atje, rrjeti nervor fillon përsëri dhe gjeneron një sekuencë të përshtatshme dalëse të shenjave, duke u mbështetur në atë që mësoi nga të dhënat e tij të trajnimit dhe rregullimi i imët.

Për shembull, kur i dhashë ChatGPT duke përdorur GPT-3, “Zapier është…” ai u përgjigj duke thënë:

“Zapier është një mjet automatizimi i bazuar në ueb që lejon përdoruesit të lidhin aplikacione të ndryshme ueb së bashku në mënyrë që të automatizojnë detyrat e përsëritura dhe të përmirësojnë rrjedhat e punës.”

Ky është lloji i fjalisë që mund të gjesh në qindra artikuj që përshkruajnë atë që bën Zapier, kështu që ka kuptim që është lloji i përgjigjës që nxjerr këtu. Por kur redaktori im i dha të njëjtën kërkesë, ai tha:

“Zapier është një mjet automatizimi i bazuar në ueb që lejon përdoruesit të lidhin aplikacione të ndryshme ueb dhe të automatizojnë rrjedhat e punës midis tyre.”

Është shumë e ngjashme, por nuk është saktësisht e njëjta përgjigje. Pyetja “Çfarë është Zapier?”, “Çfarë bën Zapier?” dhe “Përshkruani Zapier” marrin gjithashtu rezultate të ngjashme, me sa duket sepse ato zënë pozicione të ngjashme në hapësirën vektoriale. GPT e kupton se fjala më e spikatur këtu është Zapier dhe se të gjithë të tjerët po kërkojnë vetëm një përmbledhje të shkurtër në mënyra paksa të ndryshme.

Kjo rastësi (të cilën mund ta kontrolloni në disa aplikacione GPT me një cilësim të quajtur “temperaturë”) siguron që ChatGPT nuk po i përgjigjet vetëm çdo përgjigjeje të vetme me atë që përbën një përgjigje të aksioneve. Ai kryen çdo kërkesë në të gjithë rrjetin nervor dhe hedh disa zare aty-këtu për t’i mbajtur gjërat të freskëta. Kuptimi i tij i gjuhës natyrore gjithashtu e lejon atë të analizojë ndryshimet delikate midis “Çfarë është Zapier?” dhe “Çfarë bën Zapier?” Ndërsa pyetjet thelbësisht të ngjashme, do të prisnit që përgjigja të ishte paksa e ndryshme. Sido që t’i shtroni pyetje, ChatGPT nuk ka të ngjarë të fillojë të pretendojë se Zapier është një ngjyrë nga Marsi.

Për të gjithë bisedat për “të kuptuarit”, duhet të mbani mend se këto janë thjesht fjalët më të dobishme që kemi për të përshkruar se si funksionojnë AI. GPT nuk e kupton vërtet anglishten, por ka një hartë shumë të detajuar se sa koncepte lidhen me njëri-tjetrin. Prodhuesit e ChatGPT janë të parët që thonë se mund të prodhojë informacion të pasaktë (dhe ndoshta të dëmshëm), megjithëse ata po punojnë shumë për ta përmirësuar atë.

Por le të kthehemi te GPT-3 pasi gabimet e tij ofrojnë një shembull interesant të asaj që po ndodh prapa skenave në ChatGPT. Në fakt ai nuk di asgjë për ne. Nuk është as copy/paste nga interneti. Në vend të kësaj, ai thjesht parashikon një varg fjalësh që do të vijnë më pas bazuar në miliarda pikat e të dhënave që ka.

Megjithatë, është shumë mbresëlënëse se sa GPT është përmirësuar tashmë. Tani për tani, GPT-4 është i kyçur pas një abonimi premium, kështu që shumica e përmbajtjeve ChatGPT që shihni do të mbështeten në GPT-3, por kjo mund të ndryshojë gjatë kohës. Kush e di se çfarë do të sjellë GPT-5. /Katror.info