Testi kryesor publik “apple-to-apple” i aftësisë së sistemeve kompjuterike për të trajnuar rrjetet nervore me mësimin e makinerive ka hyrë në epokën e inteligjencës artificiale gjeneruese. Pasi në fillim të këtij viti MLPerf prezantoi një test për trajnimin e modeleve të gjuhëve të mëdha (LLM), veçanërisht GPT-3, këtë muaj shtoi një test gjenerues teksti në imazhin e Difuzionit të Qëndrueshëm. Standardet e reja u morën nga kompjuterët e mundësuar nga Intel dhe Nvidia, dhe beteja vazhdoi në trajnimin GPT-3, në të cilin u bashkua edhe Google. Të gjitha rezultatet janë të disponueshme për publikun dhe publikohen nga ML Commons.

Të tre lojtarët – Nvidia, Intel dhe Google – i kushtuan sistemet e tyre të fuqishme kësaj detyre, duke përfshirë superkompjuterin më të madh të testuar Nvidia me 10,000 GPU. Kjo madhësi është e nevojshme në inteligjencën artificiale gjeneruese, sepse edhe sistemi më i madh Nvidia do të merrte tetë ditë punë për të përfunduar plotësisht punën e tij LLM.

Në fund, 19 kompani dhe institucione paraqitën më shumë se 200 rezultate që treguan një performancë 2.8 herë më të lartë në pesë muajt e fundit dhe një performancë 49 herë më të lartë që nga lansimi i MLPerf pesë vjet më parë.

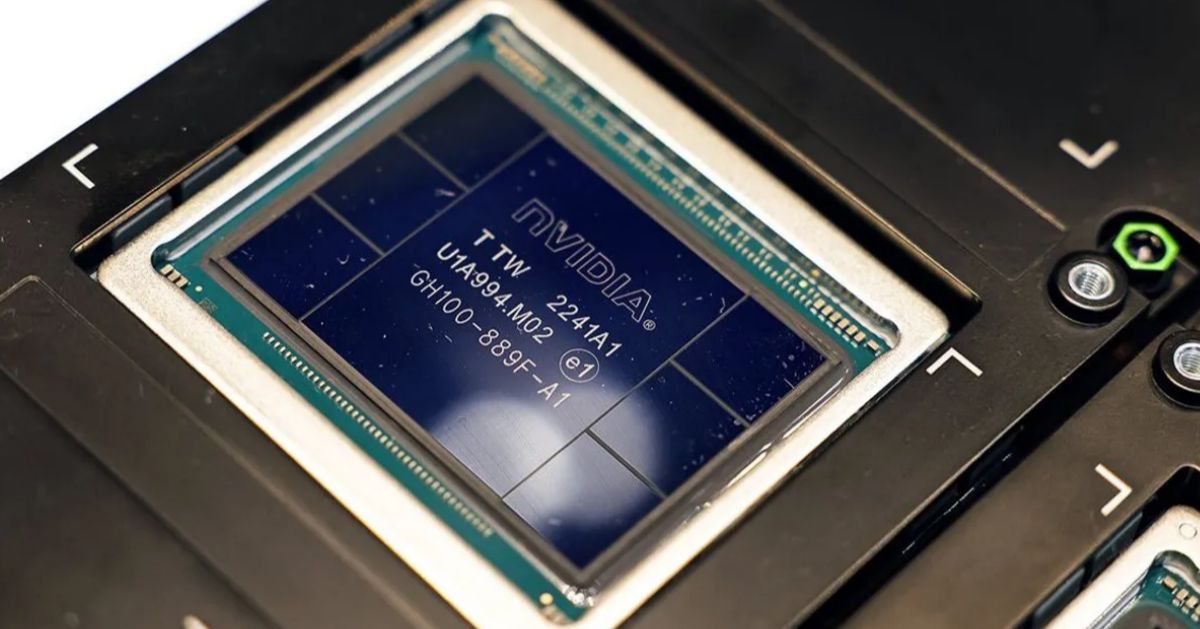

Nvidia vazhdoi të dominojë standardet e MLPerf me sistemet e ndërtuara rreth GPU H100. Vlen të përmendet rezultatet e Eos-it të tyre, një superkompjuter i ri i AI me 10,752 GPU që e bëri punën në pak më pak se katër minuta.

Platforma kompjuterike cloud e Microsoft Azure ishte vetëm disa sekonda pas Eos. Azure fuqizon ChatGPT të OpenAI dhe asistentin e kodimit CoPilot të GitHub, i cili përdoret nga më shumë se 37,000 kompani, duke përfshirë një në tre kompani të Fortune 500.

GPU-të e Eos janë të afta për një total prej 42.6 ekzaflops për sekondë dhe janë të lidhura nga Quantum-2 Infiniband i Nvidia-s, i cili transferon 1.1 milion bit në sekondë. Eos trefishon numrin e GPU-ve H100 të bashkuara në një makinë të vetme. Kjo rritje e trefishtë arriti një përmirësim të performancës prej 2.8 herë, ose një efikasitet të shkallëzimit prej 93 përqind. Shkallëzimi efektiv është çelësi për përmirësimin e vazhdueshëm të inteligjencës artificiale gjeneruese, e cila po rritet dhjetëfish çdo vit.

Standardi GPT-3 që trajtoi Eos nuk është një trajnim i plotë GPT-3 sepse MLPerf donte të ishte brenda mundësive të shumë kompanive. Në vend të kësaj, ai përfshin trajnimin e sistemit në një pikë kontrolli të caktuar që dëshmon se trajnimi do të arrinte saktësinë e kërkuar duke pasur kohë të mjaftueshme. Dhe këto trajnime kërkojnë kohë. Ekstrapolimi i katër minutave të Eos do të thotë se do të duheshin tetë ditë për të përfunduar trajnimin. Një kompjuter me madhësi më të arsyeshme si 512 H100s do të merrte katër muaj.

Intel dha rezultate për sistemet që përdorin çipin përshpejtues Gaudi 2, duke u mbështetur vetëm në CPU-të e gjeneratës së katërt Xeon. Ndryshimi i madh nga grupi i fundit i standardeve të trajnimit ishte se kompania përfitoi nga pika lundruese 8-bit (FP8), e cila ka qenë përgjegjëse për shumicën e përmirësimeve në performancën e GPU-së gjatë 10 viteve të fundit, sipas IEEE Spectrum.

Përdorimi i FP8 në pjesë të GPT-3 dhe rrjeteve të tjera nervore të transformatorëve ku saktësia e tyre e ulët nuk do të ndikojë në saktësinë e ka treguar tashmë vlerën e tij në rezultatet H100 të Nvidia, dhe tani në Gaudi 2 të Intel, i cili u tregua tre herë më i shpejtë se TPUv5e i Google.

Gaudi 2 është dukshëm më i lirë se H100 dhe ka vlerë më të mirë për paranë, thotë Intel, i cili ka shpresa të mëdha për gjeneratën e ardhshme të çipit të përshpejtuesit Gaudi 3. Ky çip do të hyjë në prodhim masiv vitin e ardhshëm dhe do të bëhet duke përdorur të njëjtin gjysmëpërçues si Nvidia H100. /Katror.info

Përgatiti: